|

|

|

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

|

|

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

|

Глава 1. Сейчас имеется несколько (даже

много) определений понятия "информация" и ни одно из них не

является общепринятым. Это естественно, поскольку общепризнанные определения

появляются в науке, когда она становится классической и перестает

развиваться. О науке об информации этого, к счастью, сказать нельзя.

· "информация есть знания,

переданные кем-то другим или приобретенные путем собственного исследования

или изучения" [4];

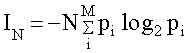

Эта величина была введена в 1948 году Клодом Шенноном [29] на примере текстового сообщения. Количество информации в сообщении, содержащем N символов IN, по Шеннону равно;

где M - число букв в алфавите,

pi - частота встречаемости i-ой буквы в языке, на котором написано сообщение,

знак " - " перед всей правой частью формулы (1.2) поставлен для

того, чтобы Ii была положительной, несмотря на то, что logq pi < 0 ( pi

< 1) . Двоичные логарифмы выбраны для удобства. При однократном бросании

монеты М=2 ("орел" или "решка"), N = 1 и pi =1/2. При

этом получаем минимальное количеств информации (I=1), которое называется

"бит". Иногда в (1.1) используются натуральные логарифмы. Тогда

единица информации называется "нат" и связана с битом соотношением:

1 бит = 1,44 ната.

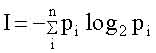

Если все варианты равновероятны,

то есть pi =1/n , то:

Ранее эпитеты

"ценная", "осмысленная" употреблялись без определения, в расчете

на интуицию. В действительности эти понятия являются центральными в

современной информатике. Уместно сделать ряд замечаний.

где p - вероятность достижения

цели до получения информации, а P - после.

Она обладает теми же свойствами,

что ценность (1,3), но изменяется от 0 до 1.

Рецепция информации - выбор,

продиктованный свыше, т.е. по указанию кого- либо или чего - либо. Иными

словами, речь идет о выборе, сделанном на основании информации, которую

данный человек (или система) принимает (название происходит от recept -

принимать).

Сперва приведем пример. Учась

говорить, ребенок рецептирует информацию об языке от своего окружения,

преимущественно от родителей. Овладев языком и грамотностью молодой человек

оказывается перед выбором свой будущей специальности. Сделав свой выбор и

овладев специальностью, человек в дальнейшем может неоднократно выбирать, в

каком направлении приложить усилия. При этом новые выборы возможны только на

основе прежних, более ранних, так как делаются человеком, владеющим не только

языком, но и специальностью. Каждый выбор делается либо случайно, либо под

влиянием внешних событий, которые часто, на первый взгляд, не относятся к

делу.

Объект, зафиксировавший ту или

иную информацию, является ее носителем. Информация, не будучи "ни

материей, ни энергией", может существовать только в зафиксированном

состоянии. При этом способы фиксации (записи) могут быть условными, не

имеющими отношения к семантике. Отсюда возникает необходимость деления

информации на условную и безусловную. Пример условной информации - код,

которым пользуются, чтобы зашифровать сообщение. Кодом называется

соответствие между условными символами и реальными предметами (и/или

действиями). Выбор варианта кода производится случайно и запоминается как

передающей, так и принимающей стороной. Ценной кодовая информация может быть

только если ею владеет несколько объектов (человек), то есть эта информация

связана с коллективным поведением (общественной деятельностью).

Начиная с работ по классической

теории информации, установилась традиция связывать информацию с

термодинамической величиной - энтропией. Начало этой традиции было положено

Н. Винером, увидевшем действительно бросающееся в глаза сходство формул

Шеннона для количества информации I и формулы Больцмана для энтропии S.

Различие в размерности устранялось выбором единиц измерения I, которое можно

измерять и в энтропийных единицах.

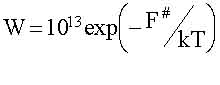

Где: 1013 сек-1 - частота

тепловых флюктуаций. Время запоминания Т= 1/W. При F# порядка 1.5 эВ время Т=

3·105 лет, что практически можно считать бесконечным.

где, nmicro число микросостояний

, W=1/nmicro - вероятность случайно выбрать какое-либо одно из них.

Количество макроинформации в том же примере, напротив мало; именно Imаcro=

log2 nmаcro = 0, поскольку макросостояние равновесного газа единственно, то

есть nmаcro = 1.

Где k=1,38 10-23 Дж/град. -

постоянная Больцмана.

В действительности формула (1.7)

представляет собой связь между энтропией и микроинформационной емкостью (или

"тарой"), поскольку сравниваются энтропия до измерения (S(t)) и

количество микроинформации после измерения I(t+t).

где W(t1t+t) - условная

вероятность того, что в момент t+t будет наблюдено то же макросостояние,

которое реализовалась в момент t. Ясно, что W(t1t+t)=1 и S(t+t)=0.

Интерпретация выражения (1.9)

такова: при увеличении информации о системе ее энтропия уменьшается. Отсюда

же происходит крылатое выражение "информация есть негоэнтропия".

Iмикро - огромное число, ибо k =

1,38 Ч10-23 Дж/К (DS < 0) ,

Одна из особенностей нелинейной динамики открытых неравновесных систем (синергетики) состоит в том, что она имеет дело с неожиданными событиями. Эти события проявляют себя как качественные скачкообразные изменения состояния системы или режима ее развития в ответ на монотонное и медленное изменение параметров. При анализе всякий раз выясняется, что причиной неожиданности оказывается неустойчивость.

В этом разделе мы приведем

основные сведения и поясним понятия теории динамических систем (или, что то

же , качественной теории дифференциальных уравнений). Полное изложение можно

найти в соответствующих математических учебниках [1-5]. Популярное изложение

содержится в книгах [6 - 9]

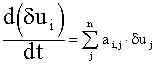

Решения системы (2.2) имеют вид:

Здесь коэффициенты ei i определяются из условий:

Откуда следует, что они

пропорциональные начальным отклонениям, (e ~ du(0)) и малы в меру малости

последних. Величины li - числа, которые являются решениями алгебраического

уравнения: det| ai,j - dij li| = 0, где dij - символ Кронекера такой, что dij

= 0 , если i № j и dij = 1 при i = j. Величины li играют важную роль в теории

устойчивости, их называют числами Ляпунова.

Числа Ляпунова при этом уже не

постоянны, а зависят от времени. Траектория является неустойчивой, если среди

чисел li(t) имеются такие, вещественные части которых положительны в

достаточно большом интервале времени Dt, таком. что Dt l(t) >> 1.

Учитывая, что за времена порядка t1 все концентрации, кроме u1, изменяются слабо и считая их постоянными, можно найти стационарную концентрацию `u1 из условия:

Используя (2.7) можно выразить

`u1 через другие переменные и таким образом сократить число дифференциальных

уравнений.

Устойчивость решения уравнения

(2.6) означает, что частная производная в (2.8) отрицательна. Число Ляпунова

при этом тоже отрицательно и очень велико (поскольку А>>1). Это

обстоятельство обеспечивает быстрое установление стационарного значения

концентрации u1 , что и является основным утверждением теоремы Тихонова.

P(x,y) и Q(x,y) известные и в

общем случае нелинейные функции своих переменных.

где зависимость y(x) - решение

алгебраического уравнения Q(x,y) =0.

Она описывает движение шарика массы m в потенциальном поле V(x) при наличии трения (коэфициент трения - g)

Первый член левой части (2.11) -

сила инерции, второй - сила трения, пропорциональная скорости.

Фазовый портрет системы (2.13)

приведен на рисунке 2.3.

не изменяется со временем.

Величина Н называется гамильтонианом, а соответствуюшие системы -

гамильтоновыми. Используется и другое название - консервативные системы. Этим

подчеркивается, что некая величина, в данном случае энергия, сохраняется.

Оно описывает движение легкого

шарика в потенциальном поле V(x) в очень вязкой жидкости. Оно же описывает

простейшую запоминающую ячейку - триггерный элемент.

Обсудим сперва свойства системы

(2.16) в симметричном случае. когда а1 =а2=а. Фазовый портрет её представлен

на рисунке 2.4.

Мы уже обсуждали вопрос о связи

информации и необратимости, имеющий принципиальное значение. В идеально

обратимом мире информация не может возникнуть, поскольку любой выбор не может

быть запомнен, ( запоминание возможно лишь в диссипативных системах). Поэтому

необратимость в нашем мире играет существенную конструктивную роль. Однако, в

фундаментальных законах классической и квантовой физики время входит

обратимо, так, что замена скоростей частиц на обратные эквивалентна повороту

стрелы времени (т.е. замене t ® - t). Иными словами, в гамильтоновых системах

явление необратимости не может иметь места.

где k = 1.38*10-16 эрг/град. -

постоянная Больцмана и W - вероятность застать систему в определенном

состоянии, где скорости и координаты шаров имеют определенное значение,

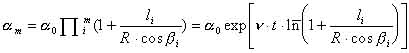

где: li -длина пробега.

где: a0 -начальное отклонение (при t=0); n- число соударений за единицу времени ( m=nt); черта над логарифмом означает усреднение по числу соударений Из (2.19) следует, что движение шара в биллиарде Синая неустойчиво, числа Ляпунова положительны и равны

Этот вывод справедлив по

отношению к любой траектории, в которой имеет место соударение с выпуклой

поверхностью. Более того, этот вывод сохраняется и для обратного процесса,

поэтому систему можно считать глобально неустойчивой.

где p0 - абсолютная величина

начального импульса. Поэтому изображающая точка движется в трехмерном

пространстве, включающем координатную плоскость и, например, импульс px .

называется энтропией Синая.

(Здесь: Г0 - элементарная ячейка фазового пространства, в классической физике

эта величина условна, в квантовой механике она ограничена соотношением

неопределенности и равна Г0 = h3n , где h - постоянная Планка и n - число

частиц) Рост энтропии связан просто с увеличением фазового объема Г(t),

обусловленного глобальной неустойчивостью.

Квантовая механика основана на двух постулатах. Первым постулатом является уравнение Шредингера:

где h - постоянная Планка, H -

оператор Гамильтона, Y - волновая функция системы.

где тильда означает комплексное

сопряжение.

Этот процесс называется

редукцией пакета.

Рассмотрим финитную систему.

Оператор Гамильтона обозначим , где индекс n соответствует определенному

набору параметров. Далее будем считать, что при изменении индекса n параметры

гамильтониана меняются мало, так, что они близки друг к другу при всех

значениях индекса n. Меру близости мы обсудим позже.

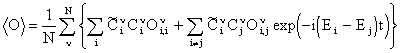

Здесь и далее индекс "i" нумеруется в порядке возрастания энергии. Развитие во времени любого состояния y(x,t) , не являющегося собственным, описывается уравнением:

(здесь и далее положено )

Диагональные элементы матрицы

плотности

где k - постоянная Больцмана.

где wi - априорная вероятность

застать систему в i-ом микроскопическом состоянии.

Величины масштаба e0 = (2)При изменении параметров энергетические уровни сдвигаются мало, то есть:

Величины масштаба

При этом и коэффициенты разложения любой функции Y (х,0) по собственным функциям n - ого и m -ого гамильтонианов также отличаются сильно.

Отсюда следует, что близкие по значению коэффициенты такие, что:

соответствуют разным значениям энергии, таким, что:

Системы, удовлетворяющие

перечисленным свойствам, будем называть параметрически (или структурно)

неустойчивыми. Термин оправдан тем, что при малом ( в меру e) и случайном

изменении параметров, коэффициенты разложения меняются тоже случайно, но

сильно.

При n > 1000 величина e0

настолько мала, что ее мы будем считать аналогом бесконечно малого (то есть

величиной типа "обратный гугол"). То же можно сказать и о

возмущениях масштаба e1.

Изменение функций Y1(х,t) и

Y2(x,t) во времени описывается выражениями (2.27), где коэффициенты

где: N - эффективное число

уровней.

Она не зависит от времени и

всегда мала.

Их разность, то есть девиация функции в момент t, равна:

Здесь мы учли, что согласно

свойству (2) и условию (2.33), собственные значения Еi ,соответствующие

разным значениям индекса n различны лишь в меру e1 (в то время как

коэффициенты Сi различаются сильно), Малым различием собственных энергий мы

пренебрегли.

хотя сами функции и коэффициенты

Сi , согласно (3), отличаются сильно.

Здесь обозначено

Из (2.44) и (2.46) следует, что

при t " (DE)-1 каждый член суммы в (2.45) не мал. Компенсация членов в

сумме (2.45) также невозможна, поскольку временной фактор не зависит от

индекса n (n=1,2), а остальные величины зависят от параметров гамильтониана и

меняются при их изменении согласно условию (3) достаточно сильно.

Обычно под наблюдаемым значением

оператора

Такая процедура уже предлагалась

и обсуждалась ранее в [32].

Представим (2.48) в виде:

Первый член - сумма диагональных

элементов, она не зависит от времени. Второй член - сумма недиагональных

членов, которая зависит от времени. Рассмотрим оба члена отдельно в случае,

когда система структурно неустойчива.

где:

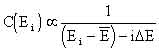

где W(E) - энергетический спектр

системы и O(E) - наблюдаемое значение оператора О в состоянии с энергией Е.

,

Интеграл (2.51) представляет

собой вклад в наблюдаемую величину диагональных членов, который мы обозначим:

итеграл в (2.52) убывает со временем экспоненциально:

В целом наблюдаемое значение

оператора

где последний член убывает со временем. В частном, но распространенном случае (2.53):

Эти соображения можно применить

к энтропии в формуле (2.30), считая, что оператор О = -k{ rlnr}i,j .

или, в случае (2.53) в виде:

В данном случае при t=0 энтропия равна нулю, поскольку исходное состояние является чистым. Это означает, что:

C учетом (2.59) выражение (2.58) можно представить в виде:

Уместно сделать ряд замечаний.

Она представляет собой

классическое выражение для энтропии в термодинамически равновесной системе.

Второй член в (2.58) соответствует сумме недиагональных членов. По знаку он

противоположен первому. Таким образом, (2.60) описывает процесс возрастания

наблюдаемой энтропии при развитии исходно чистого состояния.

Здесь большие индексы нумеруют

группы; их число меньше чем число индексов i, но все же больше, чем

"гугол". В (2.64) уже учтено, что в пределах группы корреляции

отсутствуют, поскольку они появляются на более высоком порядке (большем, чем

"гугол"). После этого можно провести все вычисления, заменяя малые

индексы бльшими, и получить тот же результат.

В разделе 2.1 были изложены

элементы теории так называемых "точечных" динамических систем,

состоящих из обыкновенных дифференциальных уравнений типа (2.1). Они

описывают развитие процессов во времена, но не в пространстве. Вместе с тем,

в синергетике многие явления развиваются как во времени так и в пространстве.

Речь идет о таких, популярных ныне, явлениях, как: образование диссипативных

структур, границ между доменами, автоволнах и т.п. В этих процессах

динамические переменные, будь то заряды, концентрации или численности живых

организмов, могут перемещаться в пространстве за счет диффузии и миграции.

Для описания их развиты специальные методы. Знакомство с ними полезно (и даже

необходимо) для понимания сути явлений. В этом разделе мы изложим эти методы,

по возможности просто и доступно. Иными словами, этот раздел (так же как и

2.1) адресуется людям. не имеющим специального математического образования,

но владеющим элементами математики.

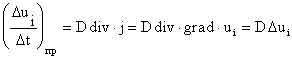

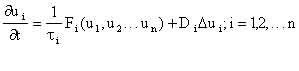

Уравнение (2.1) с учетом пространственных эффектов принимает вид

Здесь величины Di называют

коэффициентами диффузии, хотя (2.66) справедливо и в случае миграции и других

процессов распространения в пространстве без выделенного направления.

Величина

При этом перемешивание

осуществляется автоматически.

Рассмотрим уравнение, в которых

нелинейный член соответствует бистабильной системе (2.15); а все состояния

развиваются в одном направлении x (т.е.

Здесь уже выбраны соответствующие

масштабы u и x, при которых коэффициенты

По форме (2.68) совпадает с

(2.15), если положить hєt и считать V=g коэффициентом трения, который в

данном случае может принимать как положительные значения (нормальное трение,

ведущее к затуханию), так и отрицательные ("трение", ведущее к

раскачке).

По виду (2.69) аналогично

системе (2.13), но отличается от нее знаком правой части. В системе (2.69)

имеется три стационарных точки: Фокус при u=V , p=0, (устойчивый или

неустойчивый в зависимости от знака V). Два седла при р=0 и u=±1.

решается точно и решение имеет вид:

Выражение (2.71) описывает

переходную область, т. е. профиль фронта. Так, при

Образование диссипативных

структур было замечено уже давно на примере так называемых ячеек Бенара [34].

Оно заключается в следующем. На плоской сковороде подогревается масло.

Казалось бы все условия постоянны и слой масла должен нагреваться равномерно.

Однако, при достаточно интенсивном подогреве в масле появляется

пространственная структура из чередующихся потоков, направленных врех и вниз.

Соответствующая "Брюсселятору" точечная (не распределительная) система имеет вид:

Уравнения (2.73) соответствуют

некоторой гипотетической химической реакции. Компонента u1 образуется за счет

автокатализа (член

(что соответствует постановке

задачи Дирихле). Начальные условия, то есть функции u1(x,t=0) и u2 (x,t=0)

будем считать произвольными.

Решения x(х1t), h(x1t) будем искать в виде, удовлетворяющем граничным условиям (2.74):

, где

Эти уравнения уже не содержат

производных по пространственныой координате x и по форме являются точечными.

До сих пор слово

"самоорганизация" мы употребляли на интуитивном уровне. Сейчас

уместно обсудить, что оно означает, как произошло, и какую роль сыграло в

науке.

|

|

|

|

|

|

Глава 7. Методологические аспекты синергетики.

7.1. Введение.

Методология - раздел философии. Автор не считает себя профессиональным философом и действительно таковым не является. Поэтому настоящая глава не претендует на детальный анализ философских представлений, в том числе и современных. Кроме того, автор не владеет языком профессиональных философов и потому стиль изложения может у них вызвать ироническую улыбку. В этой связи уместно напомнить указ Петра Первого:

“Пехотному офицеру, проезжающему мимо кавалерийской части, надлежит спешиться и провести коня под узци, дабы видом своим не вызывать насмешки настоящих кавалеристов”. Прошу читателей считать, что в этой главе автор спешился.

Тем не менее, автор решился поделиться с читателем некоторыми соображениями, вытекающими из синергетического подхода к науке и жизни. На этот шаг автора вдохновили книги И. Пригожина, и И Стенгерс [1], С.П. Курдюмова и Е.Н. Князевой, [2] Б.Б. Кадомцева, [3] работы Н.Н. Моисеева [4] и ряда других представителей точных наук.. Из этих работ следует, что настало время философского осмысления достижений современной науки[1][1]. Тому же посвящено фундаментальное исследование В.С. Стёпина [5]. В нем подчеркнуто и другое: не только достижения естественных наук влияли на мировоззрение, но и философия, как наука универсальная, способствовала развитию точных наук. Разумеется, формулировка каждой новой модели (или теории) - акт творчества (генерации ценной информации) и потому не предсказуем. Однако, именно философия создавала эвристическую базу (или тезаурус, или объем рецептируемой информации, сь. гл. 3), которая необходима для творчества. В [5] на примере физических теорий показано, что во всех творческих актах методологические идеи (осознанно или не осознанно) играли большую эвристическую роль.

Многих ученых, в том числе и упомянутых выше, объединяет также стремление познать мир в его развитии как единое целое. Это стремление выражается словами: “всеединство” (термин предложен Флоренским), “универсальный эволюционизм” (термин предложен В.С. Стёпиным) и “редукционизм” (последний популярен преимущественно среди физиков). Смысл этих слов мы детальнее обсудим в следующем разделе.

Из предыдущих глав следует, что автора волнуют те же проблемы, что и в , чем и объясняется появление предлагаемой главы.

В главе практически отсутствуют ссылки (исключение представляют введение и раздел 7,4, в котором речь идет о конкретных вариантах логических схем). Причин тому несколько.

Во-первых, объем литературы (от Платона и Аристотеля до наших дней) таков, что автор не в силах её обозреть.

Во-вторых, образованный читатель (ученый) в первую очередь смотрит на список литературы. Если там нет ссылок на его работы, то отношение ко всему последующему в некотором смысле предопределено. Если ссылки вообще отсутствуют, то это уже не обидно и последующее воспринимается более объективно.

В третьих, философия - наука гуманитарная и мысли там выражаются словами. Слова можно трактовать расширенно и тогда выясняется, что Платоном и Аристотелем (а ещё раньше в Библии) уже всё сказано и говорить больше не о чем.

Цель главы - обсудить некоторые проблемы философии в свете достижений синергетики, а также роль философии в становлении синергетики.

Естественные науки всегда оказывали серьезное влияние на мировоззрение отдельных людей и на общество в целом. Это относится не только к гносеологии, но и этике, идеологии и даже религии. Приведем исторические примеры

В античной Греции были созданы основы геометрии и введено понятие доказательства. Потребность в этом диктовалась необходимостью делить земельные участки и доказывать, что они действительно равны. Отсюда и название - геометрия, то есть землемерие.

Задолго до этого в древнем Египте люди тоже умели делить участки и на интуитивном уровне использовали геометрию. Делали это жрецы и вместо доказательства ссылались на волю богов. В Греции боги и жрецы тоже были, но отношение к ним после создания геометрии, как науки, было уже другое.

Аксиомы Эвклида и геометрия в целом оказали очень большое влияние на развитие греческой культуры. Роль последней в античном мире общеизвестна.

То же можно сказать и о достижениях математики и механики в новой истории. Роль работ Декарта, Ньютона, Лейбница и их последователей в точных науках тоже известна. Однако, успехи математики и механики оказали влияние и на другие стороны общественной жизни, в частности на этику.

В двадцатом веке был сделан ряд крупных открытий в физике: теория относительности и квантовая механика. Значение их для физики и техники очевидно. Однако, эти открытия повлияли и на этику и на мировоззрение людей в целом, о чем речь пойдет позже.

В конце двадцатого века возникла синергетика и в её рамках было сделано открытие - теория динамического хаоса.

Это открытие по своему значению не уступает первым двум, а, возможно, и превосходит их. Роль динамического хаоса и неустойчивости в естественных науках уже обсуждалась выше. По существу вся книга посвящена именно этому вопросу. Напомним кратко основные выводы.

Появилась возможность (и даже необходимость) по новому взглянуть на. казалось бы, установившиеся понятия, такие как: причина, следствие, абсолютно замкнутая система, бесконечно большое (малое).

Появился новый объект - странный аттрактор, который, как выяснилось, имеет самое непосредственное отношение к реальной жизни.

Появилось новое понятие - перемешивающий слой, который является необходимым этапом развития живых систем. Выше показано, какую роль он играет при генерации ценной информации, в биологической эволюции, в творчестве и мышлении.

Уже из этого следует, что динамический хаос заслуживает статус великого открытия. Сейчас с этим согласятся отнюдь не все ученые. Это естественно, более того, именно так было и с теорией относительности и с квантовой механикой. Каждый ученый (и, тем более, коллектив ученых) защищает свою информацию, т.е. ту систему аксиом, которую он воспринял и которой владеет. Новая прогностическая информация воспринимается как негативная (ересь, посягательство на и т.п.). Такое поведение естественно для любого носителя информации и ученые не являются исключением. Примеры тому обсуждались выше (см. гл 4).

Однако, роль динамического хаоса не ограничивается только естественными науками, в гуманитарных науках его роль не менее важна. Более того, именно динамический хаос может сыграть роль моста между науками, т.е. служить основой для их интеграции. Открытие динамического хаоса может (и должно) повлиять и на мировоззрение в целом, включая философию и этику. Об этом и пойдет речь ниже.

7.2.Методология интеграции наук, “всеединство”, “универсальный эволюционизм” и “физический редукционизм”

. По смыслу эти термины близки, но употребляются в разных научных социях.

Всеединство - стремление понять и представить в рамках единого подхода все явления природы. Речь идет об объединении наук точных (физика, химия), естественных (биология) и гуманитарных. В этом смысле “всеединство - синоним “интеграции”. На языке теории распознавания (см. гл. 6) для интеграции нужно составить множество решающих правил и построить в нем решающее супер-правило. Для этого необходимо использовать код (т.е. язык), на котором, формулируются решающие правила.

В точных науках такой язык уже существует, это современная математика Этот язык сейчас в человеческом обществе уже универсален (т.е. общепринят). Разумеется. он является условной информацией, хотя часто воспринимается как объективная реальность, что иногда приводит к недоразумениям (примеры обсудим ниже). Вопрос: достаточен ли язык современной математики для описания всех явлений природы, является спорным и подлежит обсуждению.

В естественных и гуманитарных науках используется язык слов (вербальный код). В точных науках этот язык тоже, конечно, используется наряду с математическим. Вербальный язык более адекватен интуитивному мышлению, но для точных наук явно недостаточен.

Универсальный эволюционизм преследует туже цель - познать мир, как целое. При этом внимание акцентируется на том, что мир в целом, равно, как и наука о нем, не статичен, но развивается. В биологии и социальных науках это осознано давно. В физике - сравнительно недавно, в связи с исследованиями эволюции Вселенной. В синергетике развитие лежит в основе науки и потому её иногда отождествляют с теорией развивающихся систем.

Законы развития различных систем (Вселенной, биосферы, организма и общества) имеют много общего Эта общность связана с тем, что во всех случаях речь идет о возникновении информации и эволюции её ценности. (чему и посвящены главы 3,4,5). Поэтому формулировка общих законов развития (т.е. универсальный эволюционизм) становится актуальным направлением.

В среде физиков стремление описать все на свете в рамках единой теории (т.е. из “первых принципов”) получило название “физический редукционизм” Оно появилось сравнительно давно. В основе его лежит уверенность в том, что сложные явления природы можно свести к совокупности простых, подчиняющихся фундаментальным законам физики. Подчеркнем, речь идет именно о физике, а не о какой либо другой науке. В этом проявляется известный “физический снобизм” (Здесь следует напомнить о том, что автор сам физик и ничто физической ему не чуждо).

Уравнения Ньютона, Максвелла, Шредингера действительно фундаментальны - в этом уверены все. Достаточны ли они для описания всех явлений природы, начиная от сотворения нашего мира и до появления живых и мыслящих существ - в этом уверены не все. Именно в этом и состоит проблема физического редукционизма.

По этому поводу существуют следующие мнения:

Первая точка зрения состоит в том, что фундаментальные законы физики необходимы и достаточны для описания любого явления природы. Другие естественные науки ( химия, биология) основываются на законах физики и используют их в специальных для данной науки условиях.

Из изложенного в гл. 2 следует, что такой банальный редукционизм действительно не состоятелен. Более того, даже для “вывода” законов термодинамики уже необходима ревизия ряда понятий физики. На эту тему недавно высказались два весьма авторитетных в физике ученых: З.Б. Лафлин и Д. Пайнс. Они опубликовали статью под названием “Теория всего на свете” (“Theory of Everythink”, [6]). В ней показано, что ряд важных явлений (даже в неживой природе) невозможно описать исходя из “первых принципов”. Предложен ряд рецептов того, как обходить трудности. Предложено и новое название этих рецептов - “квантовый протекторат”. На мой взгляд авторам [6] тоже следовало бы “спешиться” и ознакомиться с тем, что уже известно в синергетике и философии. Поэтому, конструктивность рецептов работы [6] может быть подвергнута критике, но критическая часть работы сомнений не вызывает.

Вторая точка зрения в том, что фундаментальные законы физики действительно необходимы, но недостаточны для описания, например, живой природы и их необходимо дополнить. На первый взгляд это мнение противоречиво. Действительно, законы физики формулируются как полная (в математическом смысле) система аксиом. Дополнительные аксиомы приводят к переполнению системы и вступают в противоречие с основными постулатами.

Тем не менее, как показано в главах 3 и 4, именно этот вариант редукционизма может претендовать на описание явлений природы, включая живую. При этом приходится вводить новые понятия, которые в исходной аксиоматике не содержатся. Такое понимание редукционизма далее будем называть “правильным” (термин, разумеется, условен)

Существует мнение, согласно которому сложные явления (например, в живой природе и обществе) вообще не подвластны точным наукам. Это мнение противоречит стремлению познать мир в целом и на мой взгляд оно не верно по существу. Тем не менее, это мнение На первый взгляд кажется правдоподобным.. Действительно, для живых существ такие понятия как: желание, удовольствие, цель (в том числе цель жизни) естественны и осмысленны. С другой стороны точные науки (в том числе физика) до недавнего времени с этими понятиями вообще не имели дела. Однако, как показано в гл.3 и 4, и эти понятия можно сформулировать на языке физики и химии. При этом особенно важную роль начинает играть понятие ценная информация.

Упомянутые три подхода: “всеединство”, “универсальный эволюционизм” и “редукционизм” составляют основу научного мировоззрения.

Кому нужно научное мировоззрение?

Большинство ученых тратят основную часть времени и сил на решение практических задач. Для этой деятельности никакое мировоззрение не нужно.

Однако, часто встают проблемы, которые на первый взгляд кажутся неразрешимыми, обычно они называются парадоксами. Для их решения уверенность в правильности фундаментальных законов физики необходима. Отсутствие её порождает либо гиперскептицизм и робость, либо отсутствие само критицизма. Последнее ведет к фантазиям, не имеющим отношения к науке. Во избежание этого необходимо понимание фундаментальных законов физики и области их применимости, т.е. физический редукционизм в его правильном понимании. Оно же необходим для преподавателей физики. Задача педагога не только в обучении физическим методам, но и в формировании научного мировоззрения. В последнем редукционизм играет одну из главных ролей.

Наконец, научное мировоззрение нужно для всех людей (не только физиков), которые хотят видеть мир как целое, а не как набор отдельных (и часто противоречивых) явлений.

В методологическом плане главный итог книги в следующем.

Интеграция наук на основе научного мировоззрения возможна. Можно построить единую и непротиворечивую картину мира. Однако. для этого необходимо подвергнуть ревизии ряд фундаментальных понятий современной физики и математики и ввести относительно новое и не менее фундаментальное понятие - информация (точнее. ценная информация).

Можно задать вопрос: какое явление природы лежит в основе возникновения информации, что заставило ученых взволноваться? Ответ тоже прост: это явление - неустойчивость. Читатель, прочитавший книгу (а не только введение и заключение), понимает, сколь прочно информация связана с явлением неустойчивости.

На интуитивном и вербальном уровне значение неустойчивости понималось уже давно. В качестве примера часто приводят “Буриданова осла” (его приписывают средневековому философу Жану Буридану (XIV век), хотя в дошедших до нас сочинениях Буридана этот пример отсутствует). Не менее яркие примеры приводились и позже.

Однако, теория устойчивости была заложена лишь в конце прошлого века в работах А.М. Ляпунова, который ввел меру устойчивости - “число Ляпунова” Сперва это теория воспринималась как прикладная инженерная дисциплина. Её фундаментальное (методологическое) значение было осознано значительно позже и, возможно еще не полностью, поскольку дискуссии по этому поводу продолжаются.

Напомним наиболее важные следствия этого явления.

i) Ревизия понятия причины. Именно благодаря неустойчивости “причиной” может стать Его Величество Случай. Тому пример - история о том, как муха разбила хрустальную вазу (гл. 2). Случай выступает здесь не как результат незнания предыстории процесса, а как символ истинного незнания, то есть принципиальной невозможности учесть исчезающе малые влияния.

Ревизии подлежит и понятие “абсолютно замкнутой системы”. Оно понималось как предел незамкнутой системы, когда внешние воздействия исчезающе малы. В устойчивых системах такое понимание оправдано. В неустойчивых системах оно теряет смысл, поскольку возмущения нарастают со временем. При этом сама неустойчивость является внутренним свойством системы, но не внешних возмущений.

Напомним, что он же - случай - лежит в основе генерации новой ценной информации (гл. 3).

ii) Необратимость процессов во времени, или, иными словами, направление “стрелы времени”.

В современной физике фундаментальные законы сохранения связаны с симметрией. Так, сохранение импульса - следствие симметрии пространства, сохранение энергии - симметрии обращения времени. Именно поэтому фундаментальные законы физики формулируются в виде гамильтоновых систем, где обратимость времени гарантирована.

Необратимость времени влечет за собой не сохранение энергии. Последнее противоречит всему тому, что мы знаем о нашем мире.

С другой стороны, необратимость процессов во времени тоже явление фундаментальное и от него тоже нельзя отказаться.

Неустойчивость позволяет разрешить это противоречие, поскольку именно она является “причиной” такого нарушения симметрии времени, которое не нарушает закона сохранения энергии и, вместе с тем позволяет описать диссипативные процессы. При этом энергия разделяется на две части: свободную и связанную. Первая может переходить во вторую и при этом рассеивается (диссипирует), но не исчезает. Связанная энергия может переходить в свободную лишь частично, что и составляет суть второго начала термодинамики.

iii) Ревизия понятия бесконечно большого (и бесконечно малого) и введение понятия “гугол”. (числа порядка 10100 и большие). Последнее тоже чисто практическое утверждение о том, что физически реализуемые (наблюдаемые) величины такими числами выражаться не могут. Это утверждение, как практическое, сомнений не вызывало.

Фундаментальное значение его было осознано позже, и опять же оказалось, что оно связано с неустойчивостью. Именно, в неустойчивых процессах малые начальные отклонения (меньшие, чем “обратный гугол”) приводят к большим последствиям. Пренебрежение этим фактам ведет к тому, что ряд математически строгих теорем оказывается в противоречии с не менее фундаментальными законами физики (в частности, с вторым началом термодинамики).

iv) Неустойчивость является непременным условием генерации новой ценной информации. Воспринимать, хранить и передавать информацию можно и в устойчивых процессах. Более того, неустойчивость в этих процессах является только помехой. Однако, создавать ценную информацию можно только в условиях неустойчивости.

Представьте теперь, чего бы стоила теория информации и само понятие “информация”, если бы природа (живая или не живая) не могла создавать новую ценную информацию.

Из изложенного следует, что неустойчивость существенно расширяет наши представления о мире и должно играть фундаментальную роль в том. что мы называем миропониманием или научном мировоззрением. В науке 21-ого века неустойчивость будет играть роль одного из краеугольных камней. Сейчас такая наука зарождается. Название её ещё не устоялось, поэтому используют: “нелинейная динамика”, “нелинейная термодинамика” и “синергетика”. На наш взгляд последнее наиболее удачно, поскольку наименее понятно.

7.3. Синергетика и логика.

Ревизия понятий в физике и математике влечет за собой и ревизию формальной (математической) логики, поскольку именно она лежит в основе современной математики.

Логику можно рассматривать как алгоритм построения сложного суждения на основе более простых утверждений. Последние считаются заданными и играют роль начальных условий [7,8]. Сейчас предложено несколько вариантов логики, обсудим некоторые из них.

1.Классическая (формальная) логика наиболее популярна. Долгое время она развивалась как наука абстрактная, самодостаточная и прямо не связанная с проблемами насущной жизни. Основные положения её (аксиомы или алгоритмы) были сформулированы ещё в античные времена и с тех пор почти не изменились. Эти алгоритмы возникли как обобщение повседневного опыта, но на этом связь логики с реальной жизнью заканчивалась. Кратко, они сводятся к следующему.

I) Все суждения (или сообщения) разделяются на две группы: “истинные” (в математической логике им ставится в соответствие индекс “1”) и “ложные” (им соответствует индекс “0”). Алгоритм построения сложного суждения формулируется с использованием логических связок “и”, “или” и “не”. Требуется, чтобы сложное суждение тоже было либо “истинным”, либо “ложным” (верным - не верным). Иными словами, на каждый вопрос, сформулированный в рамках аксиоматики (или алгоритма) должен быть получен ответ, причем только один: “да” или “нет” (истинно -ложно, верно - не верно) Это положение известно как аксиома исключенного третьего (tertium non datur). Этим достигается однозначность суждений.

Отсюда следует, что формальная логика имеет дело с дискретным множеством объектов, о которых ставятся вопросы и выносятся суждения. Множество суждений тоже дискретно.

ii) Каждое из суждений является абсолютным, т.е. не зависящим от цели, с которой оно делается, и должно быть доказано, либо опровергнуто. Такой подход носит в себе отзвук божественного происхождения законов природы. Это значит, что на множестве объектов A,B,C, ...на вопросы типа: А или не - А, А равно В (или не равно) A>B, A<B и т.п. ответ должен быть однозначным не зависимо от меры сходства или различия. Вообще понятие меры в формальной логике отсутствует.

iii) Все элементы множества равноправны, что в частности относится и к множеству чисел.

В математике наряду с дискретными, рассматриваются и метрические континуальные множества, где вводится понятие меры. Тем не менее, равноправие чисел сохраняется. Например, если два отрезка длинами x1 и x2 отличаются на малую конечную величину Dx << x1,x2, то отрезок Dx можно “растянуть” (т.е. измерить в другом масштабе) и рассматривать как достаточно протяженный. На этом основано утверждение о бесконечной делимости отрезка. Последнее в современной математике играет существенную роль.

Успех формальной логики и построенной на её основе математики в 18-ом веке породил уверенность в том, что иначе и быть не может. В 19-ом и 20-ом столетиях эта уверенность была поколеблена. Более того, выяснилось, что система формальной логики не является полной.

Примеры неоднозначности внутри формальной логики отмечались и ранее и формулировались в виде парадоксов, таких как: парадокс лжеца и проблема буриданова осла. В строгом математическом виде неполнота системы формальной логики была доказана Гёделем.

Далее логика развивалась под давлением двух обстоятельств.

Во-первых делались (и делаются) попытки сформулировать аксиомы логики, лишенной внутренних противоречий. Эти попытки прямо не связаны с проблемами естественных наук, но могут повлиять на них косвенно.

Во-вторых, развитие естественных наук требовало уточнения ряда положений логики. Так, В 19-ом столетии выяснилось, что каждое утверждение не может быть абсолютным, но может быть сделано с определенной точностью. Последняя зависит от способа измерения, а в более общем случае, от возможности наблюдения.

Роль, которую сыграли принципы измеримости и наблюдаемости в естественных науках, общеизвестна. Они приблизили логику к реальной жизни, но разрыв ещё остался.

2. В конструктивной логике (см. [9,10] в отличие от классической, каждое утверждение подвергается конструктивной проверке путем измерения или, в более общем случае, наблюдения. Так, в классической логике на вопрос: “А или не - А” всегда должен быть получен однозначный ответ: “да” или “нет”. В конструктивной логике допускается отказ от ответа, если истинность суждения невозможно проверить.

В естественных науках такая ситуация встречается довольно часто. Если утверждение в принципе не наблюдаемо, то оно относится к категории бессодержательных.

3. В последнее время предложена релевантная (уместная) логика [11]. Она отличается от классической тем, что формально правильные, но “неуместные” логические построения в ней “отбраковываются” Благодаря этому удается избежать парадоксов, ведущих к заведомо неверным выводам.

4. В рамках многозначных логик [12] все суждения разделяются не на две, а на большее число групп. В трехзначной логике допустимы три типа ответов: “да”, “нет” и “может быть”. Последний ответ также может быть выражен словами: “не известно”, “утверждение бессмысленно” [13] или “бессодержательно”. Эти варианты отличаются в основном эмоциональной окраской. Так, ответы “не известно” или “может быть” носят субъективный характер (мне не известно, но кому то другому, возможно, известно). Слова “бессмысленно” или “бессодержательно” означают, что это утверждение не может быть доказано (или опровергнуто) в рамках всего человечества (и, возможно, в рамках Вселенной).

Соответственно увеличивается и число символов Далее, устанавливаются правила (алгоритмы) определения символа сложного суждения, если известны символы, входящих в него простых (исходных) суждений

5. Так называемая нечеткая логика (фальш-логика, fuzzy logic, [14,15]) отличается от предыдущих существенно. Каждый объект (или каждое суждение) рассматривается в ней не как эталон, а как ансамбль сходных объектов. Вместо однозначных ответов (“да” - “нет”) используются вероятностные суждения типа: с вероятностью Р - “да” и с вероятностью 1-Р - “нет”. Разумеется при этом вводится мера сходства (или различия) объектов. Привлекательность этой логики в том, что она часто (но не всегда) близка к реальности. Недостаток её в том, что соответствующий ей математический аппарат, развит ещё недостаточно. Точнее, существуют попытки создать аппарат на основе нечетких множеств, но применение его ограничено. Это не удивительно, поскольку современная математика - язык универсальный, люди им овладели и широко используют. Заменить её другой математикой равносильно предложению перейти всем на язык эсперанто.

По поводу всех упомянутых вариантов логики можно сделать ряд замечаний.

i) Понятие цели, с которой ставится задача в них отсутствует. Неявно предполагается, что любая логическая задача когда ни будь, кому ни будь для чего ни будь пригодится. Это относится как к задачам, которые имеют однозначное логическое решение, так и к задачам, которые его не имеют. Так, например, решение проблемы буриданова осла действительно необходимо для достижения конкретных целей. То же можно сказать и о других парадоксах формальной логики.

ii) Во всех упомянутых вариантах логики рассматривается постановка задачи и ответ (если он существует). В действительности построение суждения (или принятие решения) представляет собой процесс, организованный во времени. Он реализуется либо в мыслительном аппарате человека, либо в компьютере. В логике это обстоятельство ускользает от внимания. Поэтому вопрос об устойчивости логических алгоритмов до сих пор не ставился. Устойчивость процесса логического описания того или иного явления и устойчивость описываемого процесса связаны друг с другом. Поэтому устойчивость (или неустойчивость) является важным критерием любой логической задачи. На наш взгляд дефекты логических схем связаны именно с тем, что этот критерий в них не используется.

iii) В рассмотренных вариантах логики суждения считаются либо абсолютными, либо сильно размытыми (нечеткая логика). В реальности встречаются задачи обоих типов, как требующие точного ответа, так и вероятностного. Выбор какого либо одного варианта логики означает отказ от решения значительной части задач.

Из приведенных замечаний следует, что ни один из упомянутых вариантов логики не охватывает весь круг актуальных задач современного естествознания.

Возникает вопрос: как быть?

Можно в реальной жизни и в науке вообще обходиться без логики (как, собственно, и поступает большинство людей). Можно попытаться сделать следующий шаг и предложить логику более близкую к реальности. Такую логику можно условно назвать целесообразной. В её рамках любое утверждение может быть верным, не верным и бессмысленным в зависимости от условий задачи и целей её решения. Так, например, утверждение А=В верно или не верно в зависимости от того, сколь велика разница между А и В и препятствует ли это отличие достижению цели, с которой делается это утверждение. Справедливость утверждения определяется не возможностью измерить (наблюдать) отличие, а целесообразностью принимать (или не принимать) это отличие во внимание. Если отличие в принципе не измеримо, то принимать его во внимание заведомо не целесообразно.

Такое предложение может восприниматься негативно, по следующим причинам:

Во-первых, оно низводит логику до уровня прикладных наук и лишают её ореола божественности и независимости от мирской суеты. Однако, именно это обстоятельство позволяет решить наболевшие вопросы и выйти из замкнутого круга бесплодной софистики.

Во-вторых, по звучанию “целесообразная логика” представляется как нонсенс. С первого взгляда кажется, что на любой вопрос можно ответить вопросом: -“чего изволите?”. Однако, в реальных задачах такой ответ не так уж глуп. Приведем пример: В рамках формальной логики на вопрос: сколько будет 7´7 верен ответ: 7´7=49 и любой другой ответ не верен. В рамках целесообразной логики столь же верен ответ: 7´7=50. Именно этот ответ часто используют люди для прикидочных расчетов “в уме”, когда требуемая точность не велика.

В конкретных задачах целесообразная логика сводится к какому либо из известных уже вариантов логики. Так, например, если заменить понятия “истинно” и “ложно” (верно - не верно) словами “целесообразно” - “не целесообразно”, то мы вернемся к аксиоматике классической логики. При этом изменится не структура логики, а правила оценки суждения. Может оказаться, что “верный” (с точки зрения классической логики) вывод “не целесообразен” и наоборот. Примеры этого мы обсудим позже.

Таким образом, целесообразная логика не претендует на роль новой логической конструкции. Цель её введения иная, она в том, чтобы определить области применимости известных вариантов логики в естественных науках и сформулировать соответствующие критерии.

Для того, чтобы охватить в единой логической схеме весь круг задач, целесообразно указать меру размытости, обладающую следующими свойствами:

Во-первых, она должна быть конечной, но достаточно малой, такой, чтобы при решении устойчивы[AK1][AK1]х задач ею всегда можно было бы пренебречь. Это позволяет использовать в таких случаях традиционную математику без каких либо изменений.

Во-вторых, в неустойчивых процессах эта мера должна приводить к полной размытости результата. Это позволяет использовать в таких случаях традиционный вероятностный подход.

С учетом этих замечаний аксиоматику конструктивной логики можно сформулировать в следующем виде.

(1) В [AK2][AK2]каждой задаче должна быть сформулирована цель. Бесцельные задачи квалифицируются как бессмысленные и рассмотрению не подлежат. В этом смысле целесообразная логика перекликается с релевантной[2][2]

(2). Любой расчет (или алгоритм) следует рассматривать как процесс, организованный во времени т.е. проводящийся поэтапно. (что справедливо по крайней мере по отношению к компьютерным расчетам). Это позволяет поставить и решить вопрос об устойчивости и/или сходимости в рамках классической математики.

(3) Как и в классической логике каждому суждению соответствует “0” или “1”, но они рассматриваются не как символы, а как числа, близкие либо к 0, либо к 1, например, 0,000...abc или 1,000...def, где a,b,c и d,e,f - -случайные числа от 0 до 9. Это положение напоминает “fuzzy logic”, но, в отличие от последней, требуется, чтобы “размытость” была мала, порядка “обратный гугол”.

(4). Если процесс устойчив и сходится к определенному результату, то автоматически сохраняется аксиоматика классической логики (и математики). В этом случае сложное суждение будет “размыто” в ту же меру, что и исходное, Наблюдать такую “размытость” в принципе невозможно.

(5) Если процесс неустойчив, то малая “размытость” исходных суждений приводит к большой (порядка единицы) размытости “сложного” суждения. В результате суждение, “истинное” или “ложное” в рамках классической логики, оказывается ни тем, ни другим, а просто “не целесообразным” (бессодержательным). В математике это ведет к серьёзным последствиям. поскольку ряд теорем (в частности теорема Лиувилля ) при этом теряют силу.

(6). Если процесс построения суждения не сходится, то его следует остановить на любой итерации порядка гугол.

(7). Целесообразными следует считать средние характеристики ансамбля результатов расчетов неустойчивых и/или не сходящихся процессов. Усреднение проводится по результатам расчетов, отличающихся выбором произвольного числа порядка гугол (или обратный гугол). Результаты расчета каждого отдельного процесса являются не целесообразными. Динамика средних характеристик устойчива по определению среднего и расчет её подпадает под п. (4)

Перечисленные положения представляют собой алгоритм расчета процессов, как устойчивых, так и неустойчивых.

В рамках этого алгоритма отсутствуют противоречия и неоднозначности характерные для классического подхода. Для иллюстрации приведем несколько примеров.

Первый относится к проблеме временной необратимости и роста энтропии в гамильтоновых системах типа биллиарда Больцмана. В них любая траектория изображающей точки в многомерном фазовом пространстве неустойчива.

Согласно п. (3) нужно начальные условия задавать не в точке, а в малой области , не меньшей, чем обратный гугол и рассматривать поведение ансамбля точек. Согласно п. (7) целесообразно рассматривать средние характеристики ансамбля. Одной из них является энтропия, определенная, согласно Синаю как логарифм объема фазового пространства внутри всюду выпуклой оболочки, охватывающей ансамбль точек. Эта величина растет со временем и стремится к определенному пределу. По всем свойствам она совпадает с физической энтропией. Этот результат следует считать целесообразным (если, считать целью использование его для расчета, например, тепловых машин) и в этом смысле “правильным”.

С другой стороны, если рассматривать поведение отдельной траектории (что равносильно заданию начальных условий с абсолютной точностью), то каждый процесс обратим во времени и энтропия расти не может (что и составляет суть теоремы Лиувилля). Этот результат является “верным” (или “истинным”) в рамках классической аксиоматики, но, согласно (5) не целесообразным и в этом смысле “не правильным”. Результат Синая в том же смысле является целесообразным и “правильным”, хотя и “не верным” с точки зрения классической логики.

На этом примере видна разница между понятиями “истинно” (“ложно”) и “целесообразно” (не целесообразно”). Напомним, что при рассмотрении устойчивых процессов этой разницы нет.

Проблема Буриданова осла в рамках целесообразной логики решается просто. Ясно, что положение осла не устойчиво. Согласно п. (3) надлежит рассмотреть ансамбль ослов, расположенных не точно между стогами сена, а в интервале порядка гугол. Согласно п. (7) целесообразным является вопрос: как распределятся ослы в пространстве. Ответ ясен: они разделятся на две равные группы и одни пойдут направо, а другие - налево. Такое поведение ослов целесообразно, если их цель - не умереть с голоду. Вопрос: куда пойдет каждый отдельный осел ставить не целесообразно. Напомним, в рамках классической математики при точно заданных начальных условиях, осел останется стоять на месте и умрет. Такое поведение не целесообразно даже с точки зрения осла.

Парадокс лжеца, напомним, состоит в следующем: привратник имеет приказ: правдивым людям рубить голову, а лжецов вешать. Предполагается, что правдивый всегда говорит правду, а лжец всегда лжет.

К городу подходит путник. Привратник вопрошает: “кто ты, правдивый человек или лжец?”. Путник отвечает:: “я лжец”. Что должен сделать привратник?

В рамках классической логики задача решения не имеет, потому и отнесена к разряду парадоксов.

В рамках трехзначной логики любое решение лишено смысла.

В рамках релевантной логики сама задача относится к числу запрещенных.

В рамках целесообразной логики решение состоит в следующем.

В отличие от предыдущего случая промежуточное состояние исключено , а не просто не устойчиво. Каждое из разрешенных состояний (“правдивый” и “лжец”) не только не устойчиво, но и не стационарно. Процесс принятия решения состоит из последовательности итераций, каждая из которых приводит к противоположному результату. Этот процесс не является сходящимся. В рамках классической математики такой процесс представляет собой отображение предельного цикла Пуанкаре. Сам цикл устойчив, но фаза цикла не устойчива и может быть выбрана произвольно. В данном случае разрешенные состояния соответствуют противоположным фазам цикла. Таким образом, процесс не соответствует п. (4), но подпадает под п. (6).

Согласно (7) следует усреднить результаты по ансамблю итераций. Усредненный результат можно сформулировать в виде: данный путник в меру лжив и в меру правдив (что, кстати, можно отнести ко всем нормальным людям).

Если цель - определить моральный облик путника, то такой ответ следует считать целесообразным. Напротив, результат любой конкретной итерации (путник либо лжив, либо правдив) следует считать не целесообразным и не применять по отношению к нему упомянутых санкций.

Для сравнения обсудим вариант, когда путник отвечает “я всегда говорю правду”. Этот случай подпадает под п.(4). Процесс принятия решения быстро сходится к результату: путнику надлежит отрубить голову. Такое решение логически безупречно. Кроме того, оно целесообразно, поскольку человек, который всегда говорит правду, социально опасен.

На этих примерах видно, что в устойчивых ситуациях классическая и целесообразная логика не вступают в противоречие.

Обсудим ещё один пример, связанный с условностью математических понятий. Вопрос тоже актуален, поскольку в науке об информации условность играет важную роль, а в математике принято этого не замечать. В качестве примера уместно обсудить проблему “стрелы времени”.

В гамильтоновых системах выбор знака времени произволен. При описании устойчивых процессов этот произвол роли не играет, поскольку эти процессы обратимы.

В глобально неустойчивых процессах будущее отличается от настоящего и прошлого и это отличие реально, поскольку эти процессы необратимы. Однако, и в этих условиях выбор знака времени произволен и делается по общему согласию, т.е. условно.

Можно выбрать знак времени так, что в будущем оно будет более положительным, чем в настоящем (назовем таких людей оптимистами, тоже условно). Именно так считают все люди на нашей планете и потому эта условность воспринимается как объективная реальность.

Можно представить себе людей, столь же разумных, но живущих на другой планете ( или на Земле, но в другом демографическом изоляте), которые выбрали противоположный знак времени. Иными словами, они сочли, что в будущем время будет более отрицательным, чем в настоящем ( в этом тоже есть свой резон, назовем таких людей пессимистами). В обоих социях люди наблюдают одинаковые явления и описывают их одинаково, с точностью до знака времени.

Что происходит при обмене информацией между ними? Можно представить себе несколько вариантов.

i) Люди сообщают друг другу, что в будущем энтропия возрастает. Это объективная реальность и здесь вопросов не возникает.

ii) Люди посылают друг другу неравенство Больцмана, одни в форме: dS/dt >0 и другие - в форме: dS/dt <0 . Тут возникает вопрос: кто же прав?

iii) Люди посылают друг другу киноленты с изображением пожара и в сопроводительном письме указывают, где начало (настоящее) и где конец (будущее). Проблем не возникает, поскольку пожар везде протекает одинаково.

iv) Люди посылают друг другу киноленты и указывают, что кадры следует расположить в порядке возрастания (или убывания) времени, так, как это принято в каждой из соций. Тогда люди в другой соции с удивлением наблюдают, что у соседей пожар протекает не обычно: дым не расползается, а собирается, разгоревшийся пожар сам затухает, а дом сам собой восстанавливается в прежней красе. Иными словами, время у соседей течет в обратную сторону.

Здесь следует отметить, что изображение неустойчивого процесса на киноленте существенно отличается от самого процесса. Фиксация пожара в каждый момент времени на кинопленке - процесс устойчивый, это основное условие запоминания информации. Демонстрация фильма в любой последовательности кадров тоже процесс устойчивый - так устроен кинопроектор. Поэтому демонстрация фильма - процесс обратимый и этим часто пользуются кинорежиссеры. Таким образом, свойства самого процесса (пожара) и его изображения на киноленте в этом смысле существенно отличаются.

Что произойдет, когда люди, обменявшись информацией и не поняв друг друга решат встретиться? Произойдет то, что описано в гл. 3, т.е. борьба информаций, вплоть до ликвидации друг друга. В результате одна условная информация вытеснит другую и станет общепринятой. После этого все люди будут считать, что время в будущем возрастает (или убывает, в зависимости от того, кто оказался сильнее) и полагать, что это и есть истина.

В рамках формальной логики сделать выбор из равноправных вариантов (т.е. генерировать информацию) невозможно. Утверждение о том, что время в будущем возрастает (равно, как и противоположное) нельзя ни доказать, ни опровергнуть. В сущности. эта ситуация - один из примеров действия теоремы Гёделя.

В рамках целесообразной логики ценность выбора определяется тем, какая именно условная информация будет принята (или уже принята) в данном обществе. Иными словами, выбор знака времени - пример генерации условной информации, ценность которой возрастает (или убывает) со временем, в зависимости от того, какой вариант становится принятым в обществе.

Таким образом, проблема стрелы времени имеет два аспекта:

Во-первых, сама стрела связана с необратимостью процессов. Последнее имеет место в глобально неустойчивых системах, как в классических. так и в квантовых системах (см. гл. 3). Это утверждение содержит безусловную информацию.

Во-вторых, направление стрелы, т.е. выбор знака времени содержит условную информацию. Процесс выбора знака времени не имеет отношения к физическим явлениям, а, скорее, относится к социальным.

Из этого примера видно. сколь важно отличать условную информацию от безусловной, особенно. когда речь идет о математическом описании реальных процессов.

Всё сказанное выше можно изложить на языке теории распознавания.

Любая логика, точнее, алгоритм, построенный на её основе, представляет собой решающее правило, построенное на определенном обучающем множестве. Любой алгоритм формулируется на определенном языке (коде) и в силу этого условен, в ту же меру условна и логика.

Формальная (математическая) логика - решающее правило, построенное на обучающем множестве устойчивых динамических процессов. Она сформулирована на языке современной математики. Цель распознавания - прогноз поведения объектов из экзаменуемого множества, что возможно, если последнее совпадает с обучающим.

Множество устойчивых динамических систем достаточно широко. Прогнозирование их поведения на основе формальной логики оказалось достаточно эффективным. Математический аппарат в течение последних столетий был унифицирован и сейчас все человечество использует единый код - современную математику. Это обстоятельство породило иллюзию о том, что формальная логика, как решающее правило, не зависит от целей распознавания, свойств обучающего множества и условностей кода. Это заблуждение и лежит в основе парадоксов формальной логики.

Принцип исключенного третьего означает, что отказ от распознавания ни в каком случае невозможен. Это условие не может выполняться ни в каком реальном экзаменуемом множестве. В обучающем множестве оно может соблюдаться в исключительном случае, если последнее состоит только из эталонов. Однако, и в этом случае в экзаменуемом множестве обязательно найдутся объекты, которые не могут быть распознаны с помощью столь жесткого решающего правила. По существу, сказанное - парафраз теоремы Гёделя на языке теории распознавания. Так обстоит дело с “парадоксом лжеца”. Этот объект по предъявленным признакам находится между эталонами “лжец” и “правдивый” и в рамках формальной логики не может быть отнесен ни к одному из них.

Конструктивная логика - решающее правило, построенное на том же множестве устойчивых динамических систем. В отличие от формальной логики, в ней допускается отказ от распознавания.

В рамках теории распознавания отказ от ответа означает, что необходимо расширить пространство признаков. Однако, это утверждение относится, скорее, уже к целесообразной логике.

Множество неустойчивых динамических систем существенно отличается от множества устойчивых. В нём классификация может быть проведена в другом пространстве признаков и распознавание преследует иные цели. Основная цель - прогноз поведения ансамбля объектов, принадлежащих к одному классу, но не каждого объекта в отдельности. Поэтому в множестве неустойчивых систем классические логики, как решающие правила, вообще теряют силу.

Целесообразная логика в этом множестве не только констатирует бессмысленность утверждений формальной логики (что возможно и в рамках конструктивной логики), но и позволяет перейти к другому решающему правилу. Эту роль здесь играет термодинамика (точнее, статистическая физика). Важно, что язык, на котором формулируется это правило - математика - сохраняется. Изменяются лишь смысл символов, связь их с наблюдаемыми величинами и оценка значимости результатов. Иными словами, меняется физическая аксиоматика и постановка задачи,

Таким образом, целесообразную логику можно рассматривать как пример интеграции информаций, поступающих из разных обучающих множеств.

В заключение обсудим, что нового содержит целесообразная логика по сравнению с другими.

Главное в ней - использование устойчивости как критерия областей применимости уже известных вариантов логики.

Целесообразная логика не требует изменения традиционной математики. Как правило. математические расчеты начинаются словами “пусть дано ...” и кончаются “утверждение доказано”. В промежутке между ними используется математика, основанная на формальной логике. В действительности слова “пусть дано” означают, что задача идеализирована и может соответствовать реальности лишь с какой-то точностью, которая определяется целью расчета. Кроме того, по ходу вычислений часто используются предположения типа: “величина e мала и в первом приближении положим e=0”. При расчете устойчивых процессов целесообразная логика может использоваться только для оценки исходных положений и результатов. В сам расчет она не привносит ничего нового по сравнению с классической, хотя и не противоречит ей. Отличия проявляются только при расчете неустойчивых процессов. Этим и определяется область конструктивной применимости целесообразной логики.

Положение (1) о необходимости постановки цели не ограничивает область применимости целесообразной логики. В действительности определенную цель, хотя бы фантастическую, можно домыслить в любой абстрактной задаче (см. примечание).

Положения (5),(6) и (7) фактически не новы. Более того, в естественных науках они давно и с успехом используются.

Приведем пример, где эти положения используются наиболее эффективно. На наш взгляд этот пример поучителен и актуален.

Сейчас в физике активно обсуждается вопрос о том, отличается ли динамический хаос от “истинного”. Что такое “истинный” хаос с физической точки зрения не ясно. Формально разница в том, что даже неустойчивый процесс “в принципе” обратим (хотя реально это сделать невозможно). В целом постановка вопроса напоминает религиозные диспуты о “вере истинной”.

В рамках формальной логики хаотический процесс необходимо ввести, как самостоятельный, поскольку, ответ на вопрос: является ли данный процесс динамическим или хаотическим должен быть однозначным: “да” или “нет”. Иными словами, “истинный” хаос в динамических системах вообще появиться не может и его необходимо постулировать, как самостоятельный объект. При таком подходе ни о какой интеграции наук даже в рамках самой физики и речи быть не может.

В рамках конструктивной логики динамический хаос является истинным. Необходимость дополнительных постулатов о наличии других хаосов сама собой отпадает. Процесс образования хаоса необратим и энтропия при этом возрастает (теорема Синая). Слова “в принципе” здесь лишены смысла, поскольку реализовать (наблюдать) обратимость неустойчивого процесса невозможно.

В рамках целесообразной логики динамический хаос тоже является истинным, но кроме этого можно сделать и позитивное утверждение (что и было сделано). Согласно предложению Синая, энтропия исчисляется как логарифм фазового объёма внутри всюду выпуклой оболочки, окружающей ансамбль изображающих точек (о чём уже шла речь выше). Эта процедура соответствует задаче и цели расчета. В данном случае эта цель - построить математический аппарат, позволяющий - вычислять энтропию хаотических динамических систем, не только равновесных, но и не равновесных, не разрушая математическую аксиоматику, но уточняя постановку задачи на основе целесообразности..

В квантовой механике аналогичная процедура сводится к сглаживанию сильно изрезанных подынтегральных функций. Это приводит к результату, который противоречит теореме фон-Нёймана, но позволяет описать рост энтропии в хаотических квантовых системах, что и наблюдается в реальности. Цель расчета здесь такая же, как и в предыдущей задаче, но в рамках квантовой механики.

Можно привести ещё много примеров, когда физик, не задумываясь над “основами” производит усреднение по ансамблю, потому, что это “разумно” и целесообразно. По существу именно так в свое время поступил Людвиг Больцман. Поэтому формулировку этих положений мы не рассматриваем как новое слово в науке, а скорее, как констатацию факта. Тем не менее, считаем формулировку целесообразной логики полезной. Возможно, она избавит человечество от схоластических споров и призывов “давайте рассуждать логически”. Как правило, эти слова произносят люди, с логикой не знакомые и как раз в тот момент, когда “логические рассуждения” заходят в тупик.

Современный ученый (философ) стоит перед выбором, какую логику предпочесть: формальную, конструктивную или целесообразную? Ситуация такая же, как и при игре в рулетку. Выигрыш - возможность описывать явления природы с единой точки зрения. Проигрыш - опасность погрязнуть в софистических спорах. Крупье - общественное мнение ученого мира. Нужно сказать. что этот крупье на редкость инертен. Действительно в реальных задачах все ученые уже давно используют целесообразность как руководство к действию. Так, что реально шарик уже давно в лунке, но крупье ещё не сказал своего решающего слова и в дискуссиях по фундаментальным вопросам ставки ещё продолжаются.

В этом разделе мы ни словом не обмолвились о диалектической логике. Этому посвящен следующий раздел.

7.4. Порядок и хаос, логика и диалектика.

В явлениях природы есть закономерность. Это люди знали давно, и пытались понять законы природы (и до сих пор пытаются). Законы природы - это и есть порядок.

С другой стороны, уже понятые и сформулированные законы природы часто нарушаются. Многие явления происходят "случайно", то есть так, что предвидеть их невозможно. Это и есть нарушение порядка, то есть беспорядок, хаос. Такие явления играют большую роль в жизни, а в физике малекулярный хаос даже служит основой второго начала термодинамики.

В каких случаях и по каким причинам порядок уступает место хаосу? Каким образом из хаоса снова может возникнуть порядок?

Эти вопросы касаются не только бездушной природы. То же самое происходит и в живых системах (организмах, популяциях) и в человеческом обществе. Более того, в обществе проблемы порядка и хаоса даже более актуальны и стоят более остро, чем в естественных науках.

Как человечество пыталось ответить на эти вопросы?

Этому посвящены тома литературы, как научной, так и художественной. Провести обзор всего сказанного в ней автор не в силах. Однако, для дальнейшего необходимо напомнить основные этапы развития мысли. При этом не удастся избежать упрощения и даже вульгаризации истории. Поэтому прошу считать, что в этом разделе автор уже совсем “спешился”.

В религии ответ на вопрос был прост: порядок создал Бог, а беспорядок - Диавол. Этот ответ в свое время удовлетворял человечество. Действительно: посмотрите на небо: стройной чередой движутся по нему планеты и этот порядок вечен, поскольку на небе властвует Бог. На земле другое дело. Здесь "враг человеческий" силен, отсюда и беспорядок.

Однако, с развитием астрономии, физики и математики, небесный порядок был облечен в формулы и создана наука - классическая механика.

Эта наука и до сих пор является образцом порядка. Предсказания в механике однозначны. Если известны начальные условия, и силы действующие на тело, то траектория вычисляется однозначно. Успехи механики произвели большое впечатление на общество. Оказалось, что на основе законов механики можно вычислить не только движение светил на небе, но и траекторию снаряда, выпущенного из пушки и многое другое.

Широко распространилась иллюзия о том, что по аналогичным законам (столь же четким и однозначным) можно вычислить вообще все на свете.

Создатели современной механики и математики: Декарт, Ньютон, Лейбниц, Эйлер - были люди религиозные и не отказывались от роли Бога. Однако, их последователи, в частности, французские просветители, уже попытались заменить культ Бога культом Разума. Под разумом понималась способность на основании законов природы рассчитать (или предвидеть) последующие события, как в науке так и в обществе.

Это было торжество порядка над хаосом, но временное.

"Критика чистого разума" Канта снова вернула общество к извечной проблеме. Под "чистым разумом" Кант опять же понимал возможность однозначно предсказывать (вычислять, рассчитывать) явления природы. По существу Кант обратил внимание на то, что однозначно предсказывать можно отнюдь не все явления природы, более того часто результат оказывается противоположным предсказаниям "чистого разума". Впоследствии, уже в двадцатом веке выяснилось, что ни один однозначный алгоритм (подобный механике) не может дать однозначный ответ на вопрос, поставленный в рамках того же алгоритма. Сейчас это утверждение известно как теорема Гейделя.

Кант указал на ограниченность “чистого разума”, но предложить ему логическую альтернативу в рамках естественных наук того времени не мог, хотя современной ему математикой владел профессионально. Будучи человеком религиозным (как и его современники), Кант, предложил естественный для того времени выход: управляет миром Бог, а “чистый разум”, хотя и силен, но не всесилен.

Оппонентом Канта выступил Гегель. Он предложил заменить формальную логику диалектической.

Диалектика, как особый вид логики, возникла ещё в античные времена и тогда существенно отличалась от формальной логики даже по названию. Под логикой понималось искусство убеждать словом (от греческого логос - слово). Под диалектикой понималось искусство побеждать в споре (в более общем случае - вести беседу). Убеждать и побеждать - цели разные и методы их достижения тоже различны (хотя для достижения первого часто используется второе). Поэтому совместить логику и диалектику очень не просто.

В рамках изложенного в книге можно интерпретировать диалектику Гегеля следующим образом.

Гегель обобщил опыт натуралистов, наблюдавших развивающиеся системы (в первую очередь живые) и сформулировал его в виде ряда правил. Которым был придан статус законов природы. Так появился тезис о борьбе противоположностей и тезис об их смене в известной триаде: “тезис - антитезис - синтез”. Гегель, в отличие от Канта, не владел математикой профессионально и поэтому сформулировал эти правила в вербальной, но не математической форме. Справедливости ради отметим, что если бы Гегель и попытался это сделать, то всё равно не смог бы, поскольку необходимый для этого математический аппарат тогда ещё не был создан, да и сейчас он ещё только строится.

В результате область применимости диалектической логики не была четко очерчена. Вопрос о том где и какую логику следует применять оставался не решенным. Гегель понимал это и будучи, как и Кант, человеком религиозным, предоставил решение этого вопроса на усмотрение Божие. В результате диалектика Гегеля была отнесена к разряду идеалистических философий.

Научная общественность восприняла диалектику не однозначно. По существу и сейчас отношение к ней двояко.

Многие представители точных наук (физики и математики) отнеслись к ней негативно, полагая, что это не более чем слова. Тому есть причины. С точки зрения представителя точных наук слова “закон природы” подразумевают, что имеется математический аппарат, позволяющий делать однозначные предсказания. В диалектике Гегеля такого аппарата не было. Поэтому на вопрос: можно ли рассчитать и предсказать когда именно одна "противоположность" сменит другую и когда возникает "синтез", ответ был расплывчатый: "синтез" обязательно будет, но когда - не знаем. Разумеется, такой ответ представителей точных наук не удовлетворял.

Представители описательных (естественных и гуманитарных) наук встретили диалектику с энтузиазмом. Тому тоже есть причина. Гегелю удалось сформулировать основные и действительные достаточно общие свойства, характерные для открытых, развивающихся систем.

Здесь мы используем современный язык, поскольку во времена Гегеля понятия "открытая" и "развивающаяся" система были еще не сформулированы. Сейчас можно сказать, что триада Гегеля - образное описание процесса генерации ценной информации. Действительно, как было показано выше, при этом прежний динамический режим (“порядок”) становится неустойчивым и система входит в перемешивающий слой. Возникает “хаос” - антитеза “порядка”. Затем система выходит из перемешивающего слоя и входит в новый динамический режим. Возникает новый “порядок” - синтез, в котором система уже обладает новой ценной информацией. В новом режиме система развивается динамично, вплоть до следующей точки бифуркации.

Живые и социальные системы относятся именно к таковым, что и обеспечило популярность диалектики в среде биологов и гуманитариев.

Сейчас, опираясь на синергетику, можно сказать, что областью применимости диалектической логики являются все развивающиеся системы в том числе и в особенности живые. Как видим, область применимости диалектики очень широка, но не безгранична.

В неживой природе устойчивые процессы подчиняются формальной логике. Неустойчивые процессы в неживой природе тоже бывают и играют большую роль. Именно для их описания была создана теория динамического хаоса. Фактически эта теория играет роль звена, соединяющего формальную логику с диалектической.

Таким образом, области применимости формальной и диалектической логики сейчас уже определены. Сейчас сторонник диалектического мышления может ответить любому математику на его каверзный вопрос о том когда наступит “синтез”. Ответ прост: постройте математическую модель процесса и сами увидите когда именно тезис перейдет в антитезис и когда наступит синтез. В развивающейся живой системе это обязательно произойдет и это качественное утверждение диалектики остается в силе. Отметим, что ссылка на Бога при этом вовсе не обязательна (и не желательна).

Приведенные выше соображения выглядят вполне материалистическими. Поэтому, можно сказать, что современная синергетика является математической основой диалектического материализма.

В дискуссиях между сторонниками формальной логики и диалектики играло роль и другое обстоятельство, тоже не маловажное. Основы диалектики были сформулированы на вербальном (словесном) уровне, для их восприятия не нужно было знать математику. До Гегеля известные философы (включая Канта) знали математику, более того, считать себя философом не будучи знакомым с математикой было просто неприлично.

После Гегеля в философии появилось много представителей описательных наук, не знакомых с математикой, а в последнее время можно стать философом вообще не будучи специалистом ни в каких других науках.

Для людей достаточно ленивых , но склонных пофилософствовать (а таковы почти все люди), освобождение от необходимости учить математику было благом. Сейчас ситуация меняется, интеграция наук становится насущной потребностью и здесь знание смежных дисциплин (включая математику) необходимо.